บริบทและแรงจูงใจในการปรับเปลี่ยนสถาปัตยกรรม (Context and Architectural Drivers)

1.1 ข้อจำกัดของสถาปัตยกรรม Python Monolith เดิม

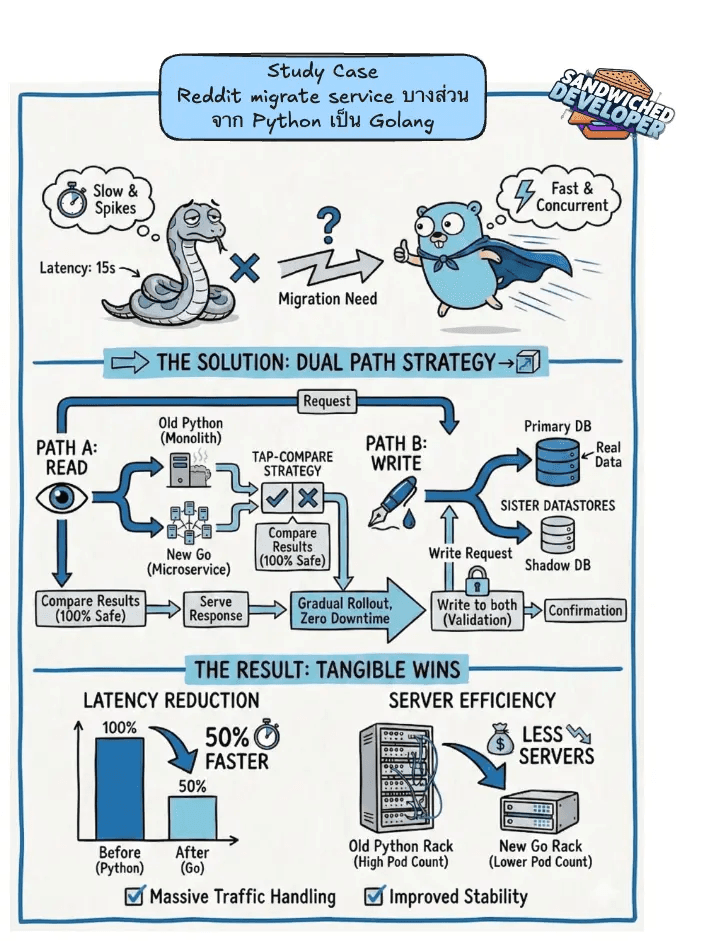

เป็นเวลากว่าทศวรรษที่โครงสร้างพื้นฐานของ Reddit พึ่งพาสถาปัตยกรรมแบบ Monolith ที่เขียนด้วยภาษา Python เป็นหลัก ซึ่งภาษา Python นั้นมีจุดเด่นในเรื่องความรวดเร็วในการพัฒนา (Developer Velocity) และมี Ecosystem ที่แข็งแกร่งในช่วงเริ่มต้นของการเติบโต อย่างไรก็ตาม เมื่อแพลตฟอร์มขยายตัวสู่ระดับ Hyperscale ระบบความคิดเห็นซึ่งเป็นหัวใจหลักของการปฏิสัมพันธ์ของผู้ใช้งานกลับเริ่มประสบปัญหาคอขวดทางเทคนิคที่รุนแรงขึ้นเรื่อยๆ 2 ปัญหาเชิงโครงสร้างที่สำคัญของระบบ Python เดิม ประกอบด้วย:

- ปัญหาด้านความหน่วงและความเสถียร (Latency and Reliability): ระบบเดิมประสบปัญหาความหน่วงที่ไม่แน่นอน (Non-deterministic Latency) โดยเฉพาะในช่วงที่มีการใช้งานสูง (Peak Traffic) ทีมวิศวกรพบว่าค่าความหน่วงที่ระดับ P99 สำหรับการดำเนินการเขียนข้อมูลที่สำคัญ (เช่น การสร้างคอมเมนต์, การแก้ไข, และการเพิ่มจำนวนโหวต) เกิดการพุ่งสูงขึ้น (Spikes) อย่างรุนแรง โดยบางครั้งอาจใช้เวลาตอบสนองนานถึง 15 วินาที 1 สาเหตุส่วนหนึ่งมาจากข้อจำกัดของ Python Global Interpreter Lock (GIL) ซึ่งทำให้การประมวลผลแบบ Parallelism บน CPU-bound tasks ทำได้ไม่เต็มประสิทธิภาพ และส่งผลให้เกิดการแย่งชิงทรัพยากร (Resource Contention) ในกระบวนการทำงานแบบ Thread-based

- ความซับซ้อนในการดูแลรักษา (Maintenance Overhead): โค้ดส่วนของระบบความคิดเห็นถูกฝังรวมอยู่กับบริการอื่นๆ ในระบบ Monolith ทำให้ความเป็นเจ้าของ (Ownership) กระจายตัวไปอยู่ในหลายทีม การแก้ไขฟีเจอร์หรือการปรับปรุงประสิทธิภาพทำได้ยากและมีความเสี่ยงที่จะกระทบต่อส่วนอื่นๆ ของระบบที่ไม่ได้เกี่ยวข้องกัน 2

- ข้อจำกัดในการขยายตัว (Scalability Constraints): โมเดลการทำงานของ Python ที่ใช้หน่วยความจำสูงต่อหนึ่ง Process ทำให้การขยายระบบ (Scaling) เพื่อรองรับปริมาณ Request มหาศาลต้องใช้ทรัพยากรจำนวนมากและไม่มีประสิทธิภาพเท่าที่ควรเมื่อเทียบกับภาษาสมัยใหม่ 1

1.2 กลยุทธ์การแยกบริการ: 4 โมเดลหลัก (The Four Core Models)

เพื่อแก้ไขปัญหาเหล่านี้ Reddit ได้กำหนดกลยุทธ์ในการแยกส่วนประกอบสำคัญออกจาก Monolith โดยระบุ "4 โมเดลหลัก" (Core Models) ที่เป็นพื้นฐานของเกือบทุกการใช้งานบนแพลตฟอร์ม ได้แก่:

- Comments (ความคิดเห็น): โมเดลที่มีปริมาณการเขียนข้อมูล (Write Throughput) สูงที่สุดและซับซ้อนที่สุด

- Accounts (บัญชีผู้ใช้): ข้อมูลอัตลักษณ์และโปรไฟล์ผู้ใช้

- Posts (โพสต์): เนื้อหาหลักที่ผู้ใช้สร้างขึ้น

- Subreddits (ชุมชน): โครงสร้างการจัดกลุ่มเนื้อหาและกฎระเบียบ

ทีมวิศวกรรมตัดสินใจเลือก Comments เป็นโมเดลแรกในการย้ายระบบ (Migration) แม้ว่าจะมีความเสี่ยงทางเทคนิคสูงที่สุดเนื่องจากปริมาณการเขียนข้อมูล แต่ก็เป็นส่วนที่จะสร้างผลกระทบเชิงบวกต่อประสบการณ์ผู้ใช้และประสิทธิภาพระบบได้ชัดเจนที่สุดหากทำสำเร็จ 3

2. การเลือกใช้เทคโนโลยี: ทำไมต้องเป็น Go? (Technology Selection: The Shift to Go)

2.1 ข้อได้เปรียบเชิงสถาปัตยกรรมของ Go (Golang)

การตัดสินใจเปลี่ยนจาก Python มาเป็น Go ไม่ได้เป็นเพียงความนิยมตามกระแส แต่ตั้งอยู่บนพื้นฐานความต้องการทางวิศวกรรมที่ชัดเจน:

- โมเดลการทำงานแบบ Concurrency (Concurrency Model): Go ถูกออกแบบมาเพื่อการทำงานแบบ Concurrency โดยเฉพาะ ด้วยการใช้ Goroutines ที่มีขนาดเล็กมาก (Lightweight) และ Channel ในการสื่อสาร (CSP - Communicating Sequential Processes) ทำให้สามารถรองรับการเชื่อมต่อพร้อมกันได้จำนวนมหาศาลโดยใช้หน่วยความจำน้อยกว่า Python อย่างมาก 4 สิ่งนี้ช่วยแก้ปัญหาคอขวดของ Thread ในระบบเดิมได้โดยตรง

- ประสิทธิภาพต่อหน่วยทรัพยากร (Resource Efficiency): ทีมโครงสร้างพื้นฐานของ Reddit ระบุอย่างชัดเจนว่า สถาปัตยกรรมใหม่ที่ใช้ Go ช่วยให้สามารถรองรับปริมาณงาน (Throughput) ที่สูงขึ้นได้โดยใช้จำนวน Pods (หน่วยประมวลผลใน Kubernetes) น้อยลงกว่าระบบ Python เดิม 1 ซึ่งสอดคล้องกับแนวโน้มการลดจำนวนเซิร์ฟเวอร์ (Server Count Reduction) เพื่อประหยัดค่าใช้จ่ายและการดูแลรักษาในระบบ Cloud 6

- ความปลอดภัยของชนิดข้อมูล (Type Safety): การเป็นภาษาแบบ Statically Typed ช่วยลดข้อผิดพลาดขณะรันไทม์ (Runtime Errors) ที่มักเกิดขึ้นในระบบ Python ขนาดใหญ่ ทำให้โค้ดมีความน่าเชื่อถือมากขึ้น

2.2 โครงสร้างพื้นฐาน Baseplate.go

ในการย้ายระบบครั้งนี้ Reddit ได้ใช้งานเฟรมเวิร์กภายในที่ชื่อว่า Baseplate.go1 ซึ่งเป็นชุดเครื่องมือมาตรฐาน (Service Framework) สำหรับการสร้าง Microservices ในภาษา Go ภายในองค์กร Baseplate ช่วยจัดการเรื่อง:

- การสื่อสารระหว่างบริการ (RPC): รองรับทั้ง Apache Thrift (เทคโนโลยีเดิม) และ gRPC (เทคโนโลยีอนาคต) ซึ่ง Reddit กำลังทยอยปรับใช้เพื่อประสิทธิภาพที่ดีขึ้น 9

- ความทนทาน (Resiliency): มีการติดตั้งระบบ Circuit Breakers, Retry Logic, และ Deadline Propagation มาในตัว เพื่อให้มั่นใจว่าบริการใหม่จะมีเสถียรภาพตามมาตรฐานระดับองค์กรทันทีที่เริ่มใช้งาน

3. ระเบียบวิธีในการย้ายระบบ: กลยุทธ์ลดความเสี่ยง (Migration Methodology)

ความท้าทายที่สุดของการย้ายระบบที่มีผู้ใช้งานจริงหลายร้อยล้านคนไม่ใช่การเขียนโค้ดใหม่ แต่คือการนำโค้ดใหม่ขึ้นใช้งานโดยไม่ให้ระบบล่มหรือข้อมูลสูญหาย Reddit จึงใช้กลยุทธ์การย้ายแบบหลายเฟส (Multi-phase Strategy) ที่เน้นการตรวจสอบความถูกต้องอย่างเข้มงวด

3.1 การตรวจสอบเส้นทางการอ่านข้อมูล (Read Path Validation): Tap-Compare

สำหรับ API ที่เกี่ยวกับการอ่านข้อมูล (Read Endpoints) ทีมงานใช้วิธีการที่เรียกว่า "Tap-Compare" หรือการทำ Shadow Traffic 1

กระบวนการทำงานมีดังนี้:

- ระบบจะส่ง Traffic จริงส่วนหนึ่งไปยังบริการ Go ตัวใหม่ควบคู่ไปกับระบบเดิม

- บริการ Go จะประมวลผลและสร้างคำตอบ (Response) ขึ้นมา

- แต่แทนที่จะส่งคำตอบของ Go ให้ผู้ใช้งาน ระบบจะทำการ เปรียบเทียบ (Compare) ผลลัพธ์กับสิ่งที่ได้จากระบบ Python เดิม

- คำตอบของระบบเดิมจะถูกส่งคืนให้ผู้ใช้ เพื่อรับประกันความถูกต้อง 100%

- หากผลลัพธ์ไม่ตรงกัน ระบบจะบันทึก Log เพื่อให้ทีมวิศวกรนำไปวิเคราะห์และแก้ไข (Debug)

วิธีนี้ช่วยให้ทีมงานสามารถค้นพบ Edge Cases หรือกรณีขอบเขตที่ซับซ้อนของข้อมูลความคิดเห็น ซึ่งมีรูปแบบสถานะ (State Combinations) เป็นพันๆ รูปแบบ ได้อย่างปลอดภัยก่อนที่จะเปิดใช้งานจริง 3

3.2 การตรวจสอบเส้นทางการเขียนข้อมูล (Write Path Validation): Sister Datastores

การย้ายระบบการเขียน (Write Endpoints) เช่น การโพสต์คอมเมนต์ มีความเสี่ยงสูงกว่ามาก เพราะหากเขียนข้อมูลผิดพลาดลงในฐานข้อมูลจริง ข้อมูลอาจเสียหายถาวร Reddit จึงคิดค้นวิธีแก้ปัญหาด้วยการสร้าง "Sister Datastores" (ฐานข้อมูลพี่น้อง) 1

โครงสร้าง Sister Datastores

ระบบความคิดเห็นมีการเขียนข้อมูลลงใน 3 แหล่งข้อมูลหลัก ซึ่งทั้งหมดถูกจำลองขึ้นมาใหม่เพื่อการทดสอบ:

- PostgreSQL: สำหรับจัดเก็บข้อมูลถาวร (Persistence) 10

- Memcached: สำหรับการแคชข้อมูล (Caching)

- Redis: สำหรับจัดเก็บเหตุการณ์ (Event Store) เพื่อส่งต่อข้อมูลผ่านระบบ Change Data Capture (CDC)

กระบวนการ Dual Write (การเขียนคู่ขนาน)

เมื่อมีคำสั่งเขียนเข้ามา:

- ระบบจะทำการเขียนข้อมูลลงในฐานข้อมูล Production ผ่านระบบ Python เดิม (เพื่อให้ระบบทำงานได้ตามปกติ)

- ในขณะเดียวกัน บริการ Go จะทำการเขียนข้อมูลชุดเดียวกันลงใน Sister Datastores ที่แยกอิสระออกมา

- จากนั้น ระบบตรวจสอบ (Verifier) จะทำการเปรียบเทียบข้อมูลระหว่าง Production Datastores และ Sister Datastores ว่าตรงกันหรือไม่

กระบวนการนี้ทำให้เกิดจุดตรวจสอบ (Validation Paths) มากถึง 18 จุด ครอบคลุมทั้ง 3 Endpoints และ 3 Datastores 1 ช่วยให้ทีมงานมั่นใจได้ว่าโค้ดใหม่ทำงานถูกต้องแม่นยำ 100% โดยไม่เสี่ยงต่อข้อมูลจริงของผู้ใช้

3.3 การจัดการ Race Conditions และข้อมูลที่ไม่ตรงกัน

ในระหว่างการทำ Tap-Compare ทีมงานพบปัญหา Race Conditions ซึ่งเกิดจากการที่ระบบ Python และ Go ทำงานไม่พร้อมกันเป๊ะๆ ทำให้ข้อมูลที่อ่านมาเปรียบเทียบอาจมีการเปลี่ยนแปลงไปแล้ว (เช่น ผู้ใช้แก้ไขคอมเมนต์ในเสี้ยววินาทีนั้น) เพื่อแก้ปัญหานี้ ทีมงานได้พัฒนาระบบทดสอบภายใน (Local Testing) ที่ใช้ข้อมูลจำลองจาก Production Traffic มาย้อนรอย (Replay) เพื่อจำลองสถานการณ์ Race Conditions และแก้ไขโค้ดให้รองรับ ก่อนที่จะนำไปทดสอบบน Production จริง 1

4. ความท้าทายทางเทคนิคและการแก้ปัญหา (Technical Challenges)

4.1 การจัดการข้อมูล (Serialization) และความเข้ากันได้

ระบบเดิมของ Python ใช้ ORM (Object-Relational Mapping) และการทำ Serialization แบบเฉพาะตัว (เช่น Pickle) ในขณะที่ Go ใช้ Structs และ JSON หรือ Protobuf ปัญหาที่พบคือข้อมูลที่เขียนโดย Go อาจมีรูปแบบไม่ตรงกับที่ระบบ Python ปลายทาง (Downstream Consumers) คาดหวัง โดยเฉพาะในส่วนของ CDC Events ที่ส่งผ่าน Redis หากรูปแบบข้อมูลผิดเพี้ยนแม้แต่นิดเดียว อาจทำให้ระบบค้นหา (Search) หรือระบบความปลอดภัย (Safety) ล่มได้ 1

วิธีแก้ปัญหา: ทีมงานไม่เพียงแค่ตรวจสอบว่าข้อมูลถูกเขียนลง Redis หรือไม่ แต่ยังตรวจสอบด้วยว่าระบบผู้บริโภค (Consumers) สามารถอ่านและประมวลผลข้อมูลที่เขียนโดย Go ได้อย่างถูกต้องสมบูรณ์

4.2 ปัญหา Write Amplification และประสิทธิภาพ Database

ในช่วงของการทำ Dual Write ระบบฐานข้อมูลต้องรับภาระหนักขึ้นเป็นสองเท่า นอกจากนี้ การที่ Go เขียนข้อมูลลงฐานข้อมูลโดยตรง (Direct SQL) ต่างจากการใช้ ORM ของ Python ทำให้เกิดรูปแบบการ Query ที่ต่างกัน และในบางกรณีทำให้เกิด "Write Amplification" หรือการเขียนข้อมูลที่มากเกินความจำเป็น ส่งผลให้ Database Load สูงขึ้น ทีมงานต้องทำการปรับจูน Query (Query Optimization) ในฝั่ง Go อย่างละเอียดเพื่อให้แน่ใจว่าประสิทธิภาพจะไม่ด้อยกว่าเดิม 1

5. ผลลัพธ์เชิงประจักษ์ (Operational Outcomes)

หลังจากการย้ายระบบเสร็จสมบูรณ์ ผลลัพธ์ที่ได้แสดงให้เห็นถึงความสำเร็จในทุกมิติที่สำคัญ:

ตารางที่ 1: การเปรียบเทียบประสิทธิภาพก่อนและหลังการย้ายระบบ

ตัวชี้วัด (Metric)ระบบเดิม (Python Monolith)ระบบใหม่ (Go Microservice)ผลลัพธ์การเปลี่ยนแปลงP99 Latency (Write)สูงและผันผวน (Spikes up to 15s)ลดลง 50% และมีความเสถียร

ประสบการณ์ผู้ใช้ดีขึ้นอย่างมาก การโพสต์คอมเมนต์รวดเร็วขึ้น 1

Latency Stabilityเกิด Spikes บ่อยครั้งขจัด Latency Spikes ได้สมบูรณ์ระบบมีความน่าเชื่อถือ (Reliability) สูงขึ้นServer Efficiencyใช้จำนวน Pods มากใช้จำนวน Pods น้อยลง

ประหยัดทรัพยากร Infrastructure และลดความซับซ้อนในการจัดการ Cluster 1

Throughputถูกจำกัดด้วย Architectureรองรับ High Throughput ได้ดีขึ้นรองรับการเติบโตของ Traffic ในอนาคตได้ดีกว่า

5.1 ประสิทธิภาพและความเร็ว (Performance & Speed)

ค่าความหน่วงที่ลดลง 50% ในระดับ P99 ถือเป็นการปรับปรุงที่มหาศาลสำหรับระบบที่มีผู้ใช้หลายล้านคน ผู้ใช้งานจริงรายงานว่าการสร้างคอมเมนต์ทำได้รวดเร็วขึ้นอย่างเห็นได้ชัด และปัญหาระบบหน่วงในช่วงที่มีผู้ใช้งานหนาแน่น (เช่น ระหว่างการถ่ายทอดสดหรือข่าวด่วน) ลดน้อยลง 1

5.2 ประสิทธิภาพโครงสร้างพื้นฐาน (Infrastructure Efficiency)

รายงานระบุชัดเจนว่า Go Microservice สามารถรองรับ Throughput ได้สูงกว่าโดยใช้จำนวน Pods ที่น้อยกว่า Python ซึ่งเป็นผลมาจากประสิทธิภาพของ Goroutines และ Runtime ของ Go การลดจำนวน Pods ไม่เพียงแต่ช่วยประหยัดค่าใช้จ่าย แต่ยังช่วยลดความซับซ้อนในการจัดการ Kubernetes Cluster และลด "Noise" ในระบบเครือข่ายภายใน 1

6. บทสรุปและก้าวต่อไป (Conclusion and Future Roadmap)

ความสำเร็จในการย้ายระบบ Comments Backend ของ Reddit ถือเป็นกรณีศึกษาที่สำคัญของการทำ Legacy Modernization ในระบบสเกลยักษ์ การเลือกใช้กลยุทธ์ "Sister Datastores" และ "Tap-Compare" แสดงให้เห็นถึงความสำคัญของการให้ความสำคัญกับความถูกต้องของข้อมูล (Data Integrity) เหนือความเร็วในการพัฒนา

การเปลี่ยนแปลงครั้งนี้ไม่ได้เป็นเพียงการแก้ปัญหาเฉพาะหน้า แต่เป็นการวางรากฐานทางเทคโนโลยีใหม่ให้กับ Reddit โดยโมเดลหลักที่เหลืออย่าง Posts และ Subreddits กำลังอยู่ในระหว่างการดำเนินการย้ายด้วยกระบวนการเดียวกัน 3 นอกจากนี้ โครงสร้างพื้นฐานใหม่ยังช่วยปลดล็อกความสามารถใหม่ๆ เช่น การจัดการ Metadata ของสื่อ (Media Metadata) ที่มีประสิทธิภาพมากขึ้นบน AWS Aurora Postgres 10 และการรองรับฟีเจอร์ที่ซับซ้อนในอนาคต ทำให้ Reddit มีความพร้อมในการรองรับการเติบโตของชุมชนออนไลน์ที่ขยายตัวอย่างไม่หยุดยั้ง